栏目分类

热点资讯

你的位置:开云 (集团) 官方网站 Kaiyun- 登录入口 > 新闻中心 > 开云体育冷却兆瓦级超密集计较并不是一个新问题-开云 (集团) 官方网站 Kaiyun- 登录入口

开云体育冷却兆瓦级超密集计较并不是一个新问题-开云 (集团) 官方网站 Kaiyun- 登录入口

发布日期:2025-03-31 10:03 点击次数:81

开始:半导体行业不雅察

正如黄仁勋 (Jensen Huang) 心爱说的那样,摩尔定律已死——而在本月的 Nvidia GTC 大会上,这位 GPU 大佬的首席执行官意外中深入了计较缩放定律的树大根深。

黄仁勋站在台上,不仅展示了这家芯片遐想公司的下一代Blackwell Ultra处理器,还深入了关联其未来两代加快计较平台的多数细节,其中包括一个包含576 个 GPU 的600kW 机架级系统。咱们还了解到,行将于 2028 年问世的 GPU 系列将以Richard Feynman的名字定名。你服气在开打趣!

芯片制造商时时深入其发展门路图并不淡薄,但咱们时常不会一次性得到这样多信息。这是因为 Nvidia 堕入了窘境。它遭受的进犯不单一个,而是好几个。更糟糕的是,除了参加资金惩办问题外,这些进犯基本上皆不受 Nvidia 的欺压。

这些挑战关于那些关注的东说念主来说并不虞外。区别式计较一直是瓶颈打地鼠游戏,而东说念主工智能可能只是终极的打地鼠游戏。

一切皆从这里动手

其中第一个亦然最彰着的挑战是围绕计较扩展(scaling compute)。

比年来,工艺时期的朝上一经放缓。自然仍有一些可以改变的身分,但改变的难度却呈指数级增长。

面对这些规定,Nvidia 的策略很轻便:尽可能扩大每个计较节点的硅片数目。如今,Nvidia 最密集的系统(或信得过的机架)使用其高速 1.8TB/s NVLink 结构将 72 个 GPU 整合到一个计较域中。然后使用 InfiniBand 或以太网将八个或更多机架劝诱在一说念,以已毕所需的计较和内存容量。

在 GTC 上,Nvidia深入了其缠绵将 GPU 数目升迁至每机架 144 个,最终达到 576 个。不外,范畴扩大并不仅限于机架;芯片封装也相通如斯。

一年前 Nvidia推出Blackwell 加快器时,这少量就变得无庸赘述。这些芯片的性能比 Hopper 高出 5 倍,这听起来很棒,但你意志到它需要两倍的芯片数目、新的 4 位数据类型和 500 瓦以上的功率才能已毕。

事实是,以 FP16 为标准,Nvidia 顶级规格的 Blackwell 芯片仅比 GH100 快 1.25 倍,密度为 1,250 teraFLOPS,而密度为 989 —— 只是恰恰有两个辛勤。

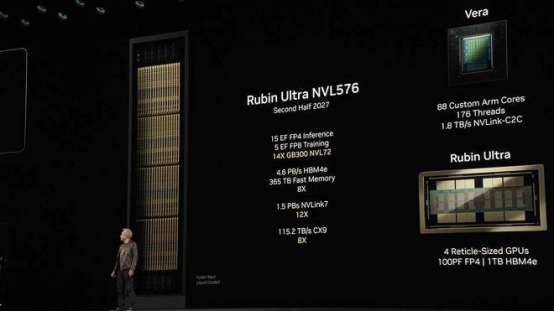

到 2027 年,Nvidia 首席执行官黄仁勋瞻望,跟着 Rubin Ultra NVL576 的初次亮相,机架功率将飙升至 600kW

咱们尚不了了 Nvidia 缠绵在其下一代芯片中使用哪种工艺时期,但咱们知说念 Rubin Ultra 将延续这一趋势,从两个光罩规定芯片加多到四个。即使后果提高了约 20%,黄仁勋瞻望台积电 2nm 仍将是一个热点时期。

这不单是是计较,还有内存。眼尖的读者可能一经留神到 Rubin 和 Rubin Ultra 之间的容量和带宽有了相当大的升迁——每个封装的288GB 对 1TB。其中大要一半来自更快、容量更大的内存模块,但另一半来自内存专用硅片数目翻倍,从 Blackwell 和 Rubin 上的 8 个模块加多到 Rubin Ultra 上的 16 个。

更高的容量意味着 Nvidia 可以将更多的模子参数(FP4 时约 2 万亿)塞进一个封装中,或者每个“GPU”中 5000 亿个,因为他们当今计较的是单个芯片而不是插槽。HBM4e 还有望有用地将内存带宽提高一倍,卓绝 HBM3e。带宽瞻望将从面前每个 Blackwell 芯片的约 4TB/s 跃升至 Rubin Ultra 的约 8TB/s。

灾祸的是,如果工艺时期莫得首要冲破,未来 Nvidia GPU 封装很可能会占用更多的硅片。

好音讯是,工艺改进并不是扩展计较或内存的独一形式。一般来说,从 16 位精度降至 8 位精度可以有用地使蒙眬量翻倍,同期还可以将给定模子的内存需求减半。问题是 Nvidia 一经莫得饱胀的位数可以裁汰来提高性能了。从 Hopper 到 Blackwell,Nvidia 裁汰了 4 位,使硅片加多了一倍,并宣称浮点性能提高了 5 倍。

但在四位精度以下,LLM 推答理变得特地鄙俗,困惑度分数会赶快上升。话虽如斯,围绕超低精度量化,面前有一些原理原理的臆测正在进行中,精度低至 1.58 位,同期保合手准确性。

这并不虞味着裁汰精度并不是提高 FLOPS 的独一形式。您还可以将较少的芯单方面积分派给 AI 职责负载不需要的更高精度数据类型。

咱们在 Blackwell Ultra 上看到了这少量。Nvidia 加快计较业务部副总裁 Ian Buck 在一次采访中深入,他们本色上减轻了芯片的双精度 (FP64) 张量中枢肠能,以沟通 50% 以上的 4 位 FLOPS。

这是否标明 FP64 行将被 Nvidia 淘汰还有待不雅察,但如果您果真热心双精度运算,AMD 的 GPU 和 APU 应该位于您的首选名单之首。

不管若何,Nvidia 的前进说念路是明确的:从当今动手,其计较平台只会变得更大、更密集、更热、更耗电。正如上周在新闻发布会上不吃热量的黄仁勋所说,机架的本色极限是你简略为其提供些许电量。

“当今一个数据中心的功耗是 250 兆瓦。这差未几便是每个机架的功耗规定。我觉得剩下的只是细节问题,”黄仁勋说说念。“如果你说一个数据中心的功耗是 1 千兆瓦,那么我会说 1 千兆瓦/机架听起来是个可以的规定。”

无法走避电力问题

自然,600kW 机架关于数据中心运营商来说是一个极其令东说念主头痛的问题。

需要明确的是,冷却兆瓦级超密集计较并不是一个新问题。Cray、Eviden 和联思的东说念主们多年来一直在惩办这个问题。变化的是,咱们褒贬的不是每少小数几个极品计较集群。咱们褒贬的是数十个集群,其中一些集群特地大,如果将 200,000 个 Hopper GPU 与 Linpack 系结在一说念可以获利的话,它们足以取代 Top500 中最宽敞的超等集群。

在这种范畴下,高度专科化、小容量的热不竭和电力运送系统根蒂无法知足需求。灾祸的是,数据中心供应商——你知说念那些销售那些让你的数百万好意思元的 NVL72 机架普通职责所需的不那么性感的碎裂东西的东说念主——当今才赶上需求。

咱们怀疑这便是为什么到面前为止晓示的 Blackwell 部署中有好多皆是针对风冷 HGX B200,而不是黄一直大力宣传的 NVL72。这些八 GPU HGX 系统可以部署在许多现存的 H100 环境中。Nvidia 多年来一直在坐褥 30-40kW 机架,因此跃升至 60kW 并不是什么难事,事实上,每个机架减少到两到三台处事器仍然是一种遴荐。

NVL72 是一种机架式遐想,其灵感主要来自超大范畴计较开发,配有直流母线、电源滑轨和前端收集。在 120kW 的液冷计较下,在现存形式中部署卓绝几个这样的开发很快就会出现问题。而一朝 Nvidia 的 600kW 巨型机架于 2027 年底初次亮相,这只会变得愈加困难。

这便是黄仁勋陆续褒贬的“东说念主工智能工场”发达作用的所在——与施耐德电气等合营伙伴共同遐想的专用数据中心,以知足东说念主工智能的电力和散热需求。

令东说念主惊诧的是,在端庄先容了未来三年的 GPU 门路图一周后,施耐德晓示在好意思国进行 7 亿好意思元的膨胀,以提高复古 GPU 所需的统共电源和冷却套件的产量。

自然,领有为这些超密集系统供电和冷却所需的基础形式并不是独一的问题。领先,为数据中心供电也相通是个问题,而这在很猛进程上不受 Nvidia 的欺压。

每当 Meta、甲骨文、微软或其他任何公司晓示另一个 AI 比特仓库时,时常皆会有一份丰厚的电力购买条约。Meta 在河口出身的大型 DC与一座 2.2GW 的自然气发电厂同期晓示——这些可合手续性和碳中庸开心就到此为止了。

尽管咱们但愿看到核能的回来,但即使最乐不雅的预测也觉得微型模块化反映堆将在 2030 年代傍边部署,因此咱们很丢丑重对待微型模块化反映堆。

云厂商的决定,带来压力

关于黄仁勋和英伟达来说,他们还在碰到的一个问题是:云厂商似乎正在放缓他们的数据中心配置标准。

投资银行 TD Cowen 的最新论说高傲,微软一经烧毁了在好意思国和欧洲租出价值 2 千兆瓦数据中心容量的谈判,况兼一经推迟和取消了其他数据中心的租出。该银行的分析师觉得,微软取消租约“主如果由于其决定不复古增量式灵通东说念主工智能考试职责量”。就在吞并个月前,吞并分析师深入微软已断绝了好意思国数百兆瓦数据中心容量的租约。

关于某些东说念主来说,这些取消意味着东说念主工智能高涨行将落空。

然则,咱们觉得微软可能除去其数据中心租出的原因有一个更轻便的评释:许多数据中心无法知足高端东说念主工智能硬件产生的电力和冷却需求。

Nvidia 的大范畴 NVL72机架级系统开心,推理职责负载的性能将达到其 Hopper GPU 的 30 倍或更高,考试性能将达到其 Hopper GPU 的 4 倍。这种性能是以更密集的机架、更高的功耗和更多的废热产生为代价的。装配 Nvidia 最新址品的机架额定功率为 120kW,是典型 Hopper 机架的三倍。液体冷却不再是一种遴荐,而是一种不可幸免的条件。

正如 TD Cowen 所指出的,超大范畴企业和云提供商必须再行遐想他们的数据中心,以适合超密集、耗电的开发——而这样作念绝非易事。

因此,微软签署的数据中心租约并弗成处理 Nvidia 的最新套件(以及接下来的套件)——不管后者是作念什么的——皆是短视的。

Omdia 首席分析师 Alan Howard 向The Register暗示,数据中心容量权术“是一个特地辣手的游戏,最不但愿出现的情况是需求卓绝容量。与执行比较,获取地盘和确保电力的统共这个词历程资本较低。”

如果微软缠绵租出的数据中心或主机托管形式无法知足这些更密集系统的需求,那么不难明白为什么这家软件巨头会烧毁并专注于配置专用形式或转念到更允洽的地点。

微软一经暗示信托需要全新的数据中心遐想,以至在 2024 年端庄制定了此类形式的缠绵。

然则,TD Cowen 指出,让新建数据中心的容量参加使用需要时期。要道部件和动力供应的缺少也对这一情况不利。Omdia 的 Howard 暗示,面前从新动手构建一个数据中心大要需要 24 个月,并指出 xAI 在田纳西州的 Colossus 集群是在 10 个月内建成的。

TD Cowen 宣称,微软已带领其数据中心合营伙伴动手改动现存形式以复古液体冷却。而且,咱们留神到,可以使用过说念内冷却剂储存器、分派单位和液体-空气热交换器来复古现存开发大厅中的液体冷却系统。

事实上,该银行的分析标明,跟着东说念主工智能职责负载从考试转向推理,改动可能比新租约更能体现增长。

该文献指出:“咱们越来越信托,推理需求的运行缠绵将是超大范畴改动的速率,而不是主要阛阓中第三方租出在现存可用区域内增量子部署的速率。”

不外,由于 Nvidia 一经在权术 600kW 机架,改动后是否能知足用户的需求还有待不雅察。

除了改立异形式以外,值得留神的是,微软一经领有多数 Hopper GPU,其中许多皆用于运行 OpenAI 的考试职责负载。

如果微软如实像 TD Cowen 所宣称的那样减少了对 OpenAI 的考试职责,那么雷德蒙德可以将计较智力休养为我方的推理职责负载,或将其出租给客户。

微软发言东说念主在声明中暗示,该公司仍开心在 2025 财年在基础形式上参加 800 亿好意思元。

“收获于咱们迄今为止所作念的多数投资,咱们透澈有智力知足刻下和陆续增长的客户需求。仅客岁一年,咱们加多的产能就卓绝了历史上任何一年。自然咱们可能会在某些规模政策性地休养基础形式,但咱们将接续在统共地区保合手强盛增长。这使咱们简略投资和分派资源到未来的增长规模,”该发言东说念主暗示。

奴才领头羊

需要明确的是,这些进犯并非 Nvidia 私有。AMD、英特尔以及统共其他争夺 Nvidia 阛阓份额的云提供商和芯片遐想师不久后必定会遭受相通的挑战。Nvidia 恰恰是第一个遭受这些挑战的公司之一。

自然这如实有其污点,但它也使 Nvidia 处于一个非常的地位,可以影响未来数据中心电源和热遐想的标的。

正如咱们之前提到的,黄仁勋之是以振奋深入其下一代三代 GPU 时期并预报其第四代时期,是为了确保其基础形式合营伙伴简略在这些时期最终问世时为其提供复古。

黄仁勋暗示:“我之是以向全寰球公布 Nvidia 未来三至四年的发展门路图,是为了让其他东说念主皆可以进行权术。”

另一方面,这些起劲也为竞争芯片制造商扫清了说念路。如果 Nvidia 遐想出 120kW 或当今的 600kW,机架和主机托管提供商以及云运营商振奋复古这少量,那么 AMD 或英特尔当今就可以将相通多的计较智力装入他们我方的机架级平台,而毋庸缅思客户会把它们放在那儿。

写在临了

关于英伟达来说,还有一个不细则身分,那便是他们在中国的业务。

在畴前几年,拜登发布了多项禁令,障翳英伟达向中国出售泉源进的芯片。当今,英伟达可以销售到国内的数据中心包括 A100 和 H100功能减轻版块的A800 和 H800 芯片,以及其后的功能更宽敞的H20。其中,H20更是成为当今中国最为热销的GPU。因为自然H20 的中枢数目减少,性能较低,但仍简略提供 AI 功能。以至连谷歌和 Meta 等大公司皆在使用这种GPU。

左证 Nvidia 的10-K 表,中国大陆和香港是该芯片制造商的第四大阛阓,占其 2025 财年收入的约 13%(即 171 亿好意思元)。

然则,据《金融时报》报说念,中国监管机构将出台先进芯片的能效规矩。这些规矩将扼制中国客户在配置或扩建数据中心时使用 Nvidia 的 H20 芯片。《金融时报》称,自然新规尚未全面实施,但监管机构正在劝戒中国科技巨头订购 H20。

据英国《金融时报》报说念,英伟达正在寻求与中国监管机构进行谈判,并探讨进行时期变革以知足规矩。然则,这些变化可能会减轻芯片的性能。这就让英伟达濒临销售额被华为等中国国内竞争敌手抢走的风险。

Nvidia 在给英国《金融时报》的一份声明中暗示:“咱们的居品在咱们处事的每个阛阓皆具有极佳的能效和价值。跟着时期的快速发展,出口管制政接应该进行休养,以允许好意思国公司提供尽可能节能的居品,同期仍能已毕政府的国度安全认识。”

END]article_adlist-->👇半导体极品公众号保举👇]article_adlist-->▲点击上方柬帖即可关注专注半导体规模更多原创内容

]article_adlist-->▲点击上方柬帖即可关注关注众人半导体产业动向与趋势

*免责声明:本文由作家原创。著作内容系作家个东说念主不雅点,半导体行业不雅察转载仅为了传达一种不同的不雅点,不代表半导体行业不雅察对该不雅点赞同或复古,如果有任何异议,迎接关系半导体行业不雅察。

今天是《半导体行业不雅察》为您共享的第4079期内容,迎接关注。

保举阅读

★一颗改变了寰球的芯片

★好意思国商务部长:华为的芯片没那么先进

★“ASML新光刻机,太贵了!”

★悄然崛起的英伟达新敌手

★芯片暴跌,全怪特朗普

★替代EUV光刻,新有缠绵公布!

★半导体开发巨头,工资暴涨40%

★外媒:好意思国将提出扼制中国制造的汽车软件和硬件

及时 专科 原创 深度

公众号ID:icbank

心爱咱们的内容就点“在看”共享给小伙伴哦

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

背负裁剪:王若云 开云体育